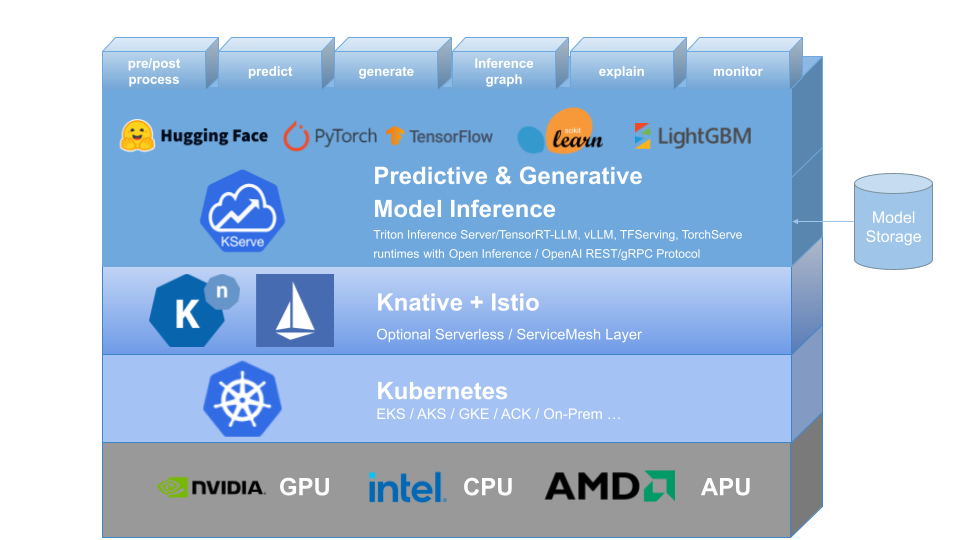

BentoML

BentoML is the easiest way to serve AI apps and models - Build Model Inference APIs, Job queues, LLM apps, Multi-model pipelines, and more!

BentoML 是一个灵活的AI应用服务框架,致力于简化从模型到生产级API服务的打包和部署过程。

侧重易用性和应用构建,适合打包完整AI云端服务。

https://github.com/bentoml/BentoML